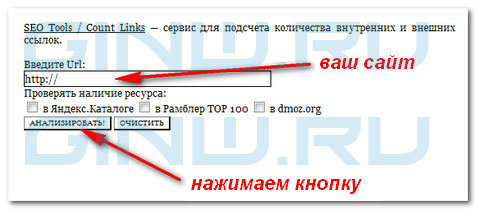

Зачастую используется «метод исключения» перебирая возможные проблемы, итак: с начала надо проверить количество внешних и внутренних ссылок. Как многим известно, для того, чтобы проверить количество внешних и внутренних ссылок, можно воспользоваться сервисом www.dinews.ru/seo/ и в появившемся окне, пишем название сайта и нажимаем кнопку анализировать:

Ожидаем некоторое время и получаем ответ на запрос:

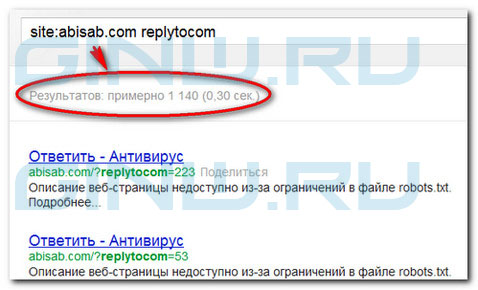

На сайте обнаружилось 186 штук таких ссылок ?replytocom= на главной странице, что уже не допустимо (должно примерно в этих рамках от 80-120, желательный предел).

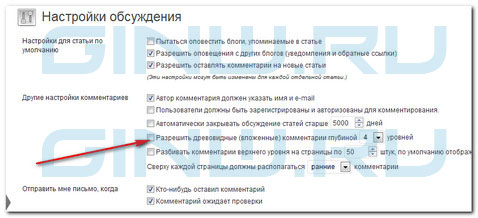

Все дело оказалось в древовидных комментариях.

Параметры -> Обсуждение:

При нажатии на кнопку «ответить» в комментарии, создается такая же страница как и без этого комментария — происходит дублирование контента (страницы), из-за чего сайты попадают под фильтры АГС, также на сайте www.cy-pr.com при просмотре статистики видно, что Google загоняет под фильтры большое количество страниц, поэтому просто необходимо убрать лишние внутренние ссылки.

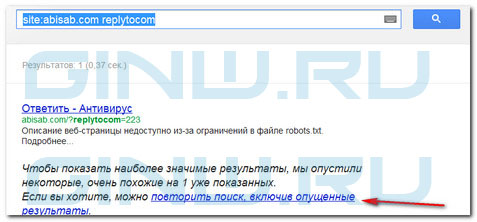

Для того, чтобы узнать есть у вас такие ссылки на сайте вводим в строке браузера Google -> site:sitename.ru replytocom, причем там где стоит название abisab.com надо написать имя Вашего сайта, получаем ответ:

Нажимаем на -> повторить поиск, включив опущенные страницы.

Решить данную проблему можно такими способами:

1. Использовать плагин Replytocom Redirector, но по отзывам — данный плагин (на момент написания статьи) не справляется со своей задачей и не выполняет необходимую функцию «редирект».

2. Удалить URL адреса из поисковой выдачи Google эти страницы и только после этого запретить древовидные комментарии, причем необходимо выполнить это именно в таком порядке.

3. В файле robots.txt надо добавить записи:

— Disallow: /*?replytocom

— Disallow: /*?*

Причем нижняя запись из всех присутствовала на сайте в файле robots.txt (на момент написания статьи). Логически понятно, что записи Disallow: /*?replytocom и Disallow: /*?* отличаются не только визуально, но и функционально. По этой причине и говорят, что Google не реагирует на эти записи. Google в поисковой выдаче обычно пишет: описание веб-страницы недоступно из-за ограничений в файле robots.txt. С поисковиком Яндекс проблем не возникает и контент не дублируется, если прописать эти строчки в robots.txt.

3а) Прежде, чем приступить к пункту 3б) необходимо удалить URL адреса из поисковой выдачи Google эти страницы.

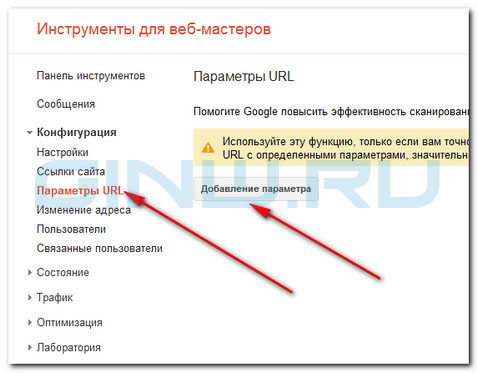

3б) Что касается Google, то здесь в настройках вебмастера https://www.google.com/webmasters/tools/ нужно выбрать необходимый сайт, если у Вас их несколько, затем переходим во вкладку конфигурация и Параметры URL:

Нажимаем «добавление параметра»

Информация от Google: Используйте эту функцию, только если вам точно известно, как тот или иной параметр влияет на работу вашего сайта. Если вы по ошибке запретите Google сканировать URL с определенными параметрами, значительная часть страниц вашего сайта может пропасть из результатов поиска

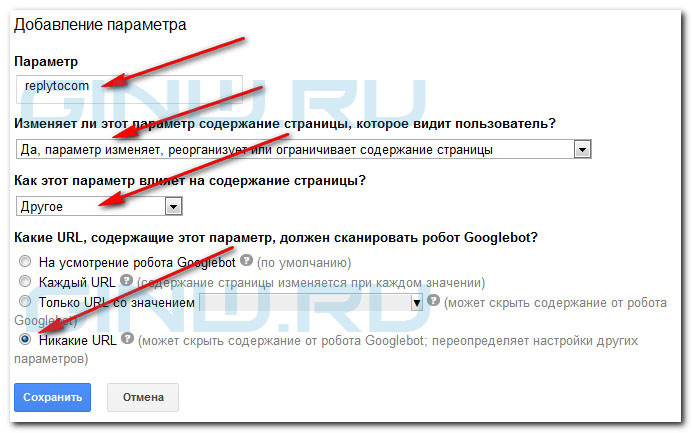

Далее для того, чтобы полностью исключить появление дублирование контента от комментариев делаем так, как на рисунке ниже:

Никакие URL. Робот Googlebot не будет сканировать URL с выбранным параметром. В частности, если выбрать настройку, при которой робот Googlebot не сканирует URL с параметрами pricefrom